企业AI安装部署

主要涉及到部署知识库和AI大模型,部署方式很灵活,可以部分线上部署部分线下部署(一般知识库线下部署,大模型线上部署,保证企业数据的隐私性)

此教程需要您对Ragflow的安装使用有基本了解,会自定义Agent工作流,网上有很多相关资料,如不想学习可以联系客服付费代为部署定制

部署流程

- 安装Ollama

- 安装指定的大模型

- 安装Git

- 安装Docker

- 安装RagFlow知识库

- 配置RagFlow默认模型服务商

- 企业知识库服务器设置

- 业务OpenAI API配置

- 助手OpenAI API配置

- RagFlow配置Agent

- 配置系统的AI业务员

- 开启私信自动回复开关

一,安装Ollama

Ollama是一个大模型快速安装部署的工具,安装了Ollama之后可以方便快速的安装各类大模型,大模型的运行十分消耗算力,对硬件要求很高,模型参数越大,越智能,算力配置要求越高,如果想要更好的效果推荐云端镜像的安装方式(可以依照使用时间付费)

安装方式有下面两种

1.本地下载安装(完全免费,适合本地电脑配置比较高)

进入Ollama下载页面,下载客户端安装即可

下载安装完之后,需要安装指定大模型,直接打开电脑的命令行(终端),

比如我们要安装qwen3:14b大模型,命令行(终端)输入

ollama pull qwen3:14b回车即可2.云端镜像安装(按时间收费,适合对AI输出质量有要求的企业)

我们在仙宫云上定制了一个Ollama镜像,Ollama镜像地址,根据此镜像直接部署就行

如果您需要部署参数量比较大的模型,建议部署的时候增加GPU数量,系统盘额外扩容

如何获取Ollama服务的外网访问地址,以及如何安装大模型,请查看Ollama镜像地址,里面有详细说明

二,安装大模型

模型需要安装三类

- 嵌入模型

- 聊天模型

- Img2txt模型(和聊天模型类似,区别是支持视觉)

WARNING

当前演示的都是参数量很小的模型,可以根据您的算力资源,适当安装大参数的模型,获得更好的效果

嵌入模型选择

访问嵌入模型列表,里面是所有可用的嵌入模型 我们选择以bge-m3为例,依照上一步骤,命令行(终端)输入

ollama pull bge-m3回车即可聊天模型的选择

我们一般选择qwen3,其各种版本如下地址,根据你机器配置,选择安装 我们选择以8b为例,依照上一步骤,命令行(终端)输入

ollama pull qwen3:8b回车即可Img2txt模型(图像识别模型)

访问视觉模型列表,里面是所有可用的嵌入模型 我们这里选择gemma3,其各种版本如下地址,根据你机器配置,选择安装 我们选择以4b为例,依照上一步骤,命令行(终端)输入

ollama run gemma3:4b回车即可

三,安装Git

根据您的系统类型,进入对应的安装说明页面,按照页面提示下载安装即可

四,安装Docker

五,安装RagFlow知识库

按照官方安装说明,按照步骤安装即可

网上有很多Ragflow的教程,bilibili上有很多相关教程说,可以自己搜索了解一下基本使用,如下 bilibili

六,配置RagFlow默认模型服务商

确定您的Ollama服务地址

- 如果你的Ollama是本地安装的,并且RagFlow是通过Docker访问你本地Ollama的,所以你的你的Ollama服务地址是

http://host.docker.internal:11434

- 如果你的Ollama是云端镜像安装的,请查看Ollama镜像地址里面的说明,获取到Ollama服务地址比如

https://kr4ifmcbkbm4gtol-11434.container.x-gpu.com

七,企业知识库服务器设置

您本地知识库访问地址为http://127.0.0.1,浏览器打开此地址,注册并登录账号

按照下面视频操作步骤,将API地址和密钥配置到系统的指定位置

八,业务OpenAI API配置

配置业务OpenAI API账号信息,用于AI客户筛选,AI生成文案,AI国家识别等

- API 设置

- 如果你的Ollama是本地安装的,你的Ollama服务地址是

http://127.0.0.1:11434,API应该填http://127.0.0.1:11434/v1 - 如果你的Ollama是云端镜像安装的,请查看Ollama镜像地址里面的说明,获取到Ollama服务地址比如

https://kr4ifmcbkbm4gtol-11434.container.x-gpu.com,API应该填https://kr4ifmcbkbm4gtol-11434.container.x-gpu.com/v1

- key设置

固定填ollama

- AI大模型设置

根据您设置的聊天大模型设置对应名称,此教程使用的是qwen3:8b,填入qwen3:8b即可

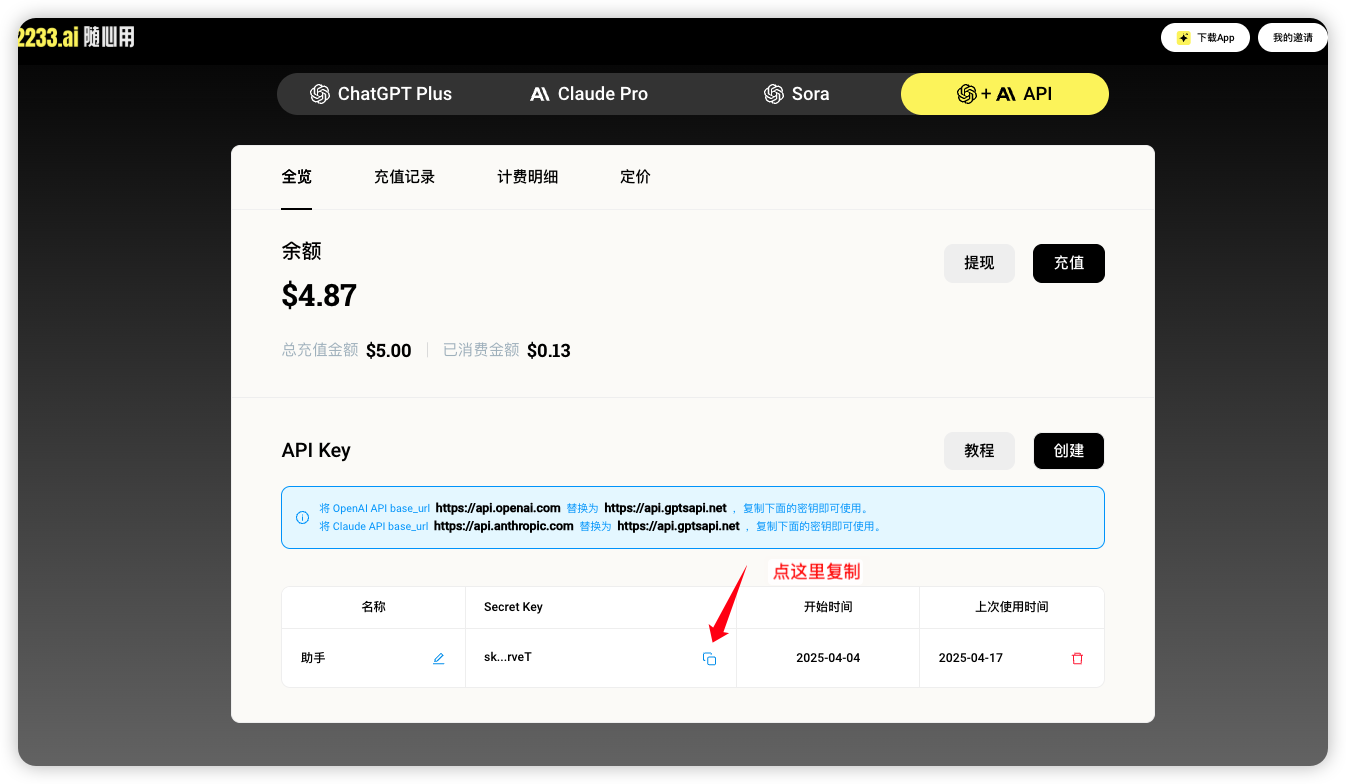

九,助手OpenAI API配置

主要用来实现AI助手的功能,如果用到了企业AI中的系统助理功能,这里需要设置,目前测试情况ChatGPT效果最好

ChatGPT服务建议到2233AI随心用网站注册充值,完了打开API中心创建Key,完了可以复制您的Key信息

- API地址

一般固定填 https://api.gptsapi.net/v1

- Key设置

- Ai大模型设置

固定设置 gpt-4o-mini

十,RagFlow配置Agent

配置Agent之前建议看一下RagFlow的Agent例子教程,构建智能客服案例

系统提供三个Agent模版

在RagFlow创建空白的Agent,导入即可,注意模版Agent只是流程例子,其中部分节点,比如选择知识库,设置的AI模型节点,提示词等根据您自己的需求需要调整一下

WARNING

无论您这边如何调整,需要考虑Agent碰到无法解决的问题,就应该固定输出N001,并且不要修改启始节点的输入项,这是我们系统与Agent达成的规范

十一,配置系统的AI业务员

上一步配置好对应的Agent之后,在我们系统的AI业务员设置界面,根据不同的业务员角色,选择不同Agent即可

十二,开启私信自动回复开关

点击软件右上角的面板按钮,找到私信自动回复的区域,点击开启所有即可